Dr Joachim Dengler

Publié le 25 août 2024 sur le site de Judith Curry, cet article fait suite à un premier article publié par la revue Atmosphere sous le titre Improvements and Extension of the Linear Carbon Sink Model que nous avions traduit et publié sur le site de l’ACR site le 16 août 2024.

Le modèle de puits de carbone linéaire présente une limitation

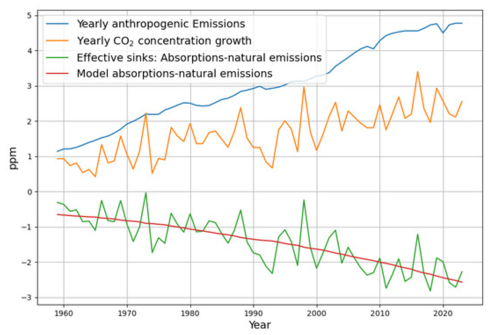

La relation entre les émissions de CO2 et la concentration résultante des 65 dernières années peut être mieux comprise à l’aide d’un modèle descendant simple [NDT top-down model], où l’effet de puits net, qui est la différence entre les émissions anthropiques et la croissance de la concentration atmosphérique de CO2, est modélisé avec une fonction linéaire de la concentration atmosphérique de CO2 comme le montre la figure 1. Il est important de noter que l’effet de puits net représente en fait la somme de toutes les absorptions – océaniques, végétales terrestres et phytoplanctoniques – après déduction des émissions naturelles.

L’interprétation du modèle est que le facteur de proportionnalité de la relation linéaire est une somme des facteurs de proportionnalité inconnus de tous les processus d’absorption contributeurs, tels que la photosynthèse des plantes terrestres, la photosynthèse du phytoplancton et l’absorption physique des océans. Il a été démontré que tous ces processus sont des fonctions approximativement linéaires de la concentration atmosphérique en CO2, ce qui justifie que leurs facteurs de proportionnalité puissent être additionnés. La constante du modèle linéaire est interprétée comme les émissions naturelles. Cela suppose implicitement que les émissions naturelles sont considérées comme étant approximativement constantes.

Extension du modèle de puits linéaire

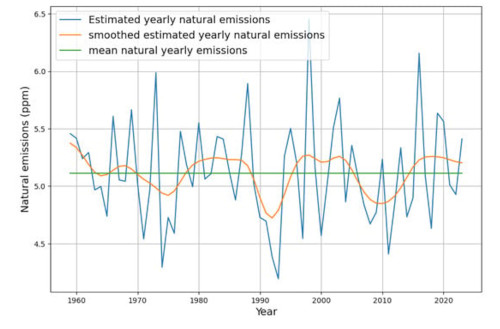

Bien que la proportionnalité entre absorption et concentration soit physiquement très bien fondée, l’hypothèse d’émissions naturelles constantes semble arbitraire. En effet, cette constante supposée contient la somme de toutes les émissions, à l’exception des émissions explicitement anthropiques, mais aussi de tous les puits qui sont équilibrés au cours de l’année. Il est donc éclairant de calculer les émissions naturelles estimées à partir des données mesurées et du modèle linéaire de puits de carbone comme le résidu après modélisation de l’absorption comme proportionnelle à la concentration. Ceci est illustré par la figure 2. La valeur moyenne des émissions naturelles estimées donne le terme constant du modèle. Un léger lissage donne une courbe périodique. Roy Spencer a attribué ces fluctuations à El Niño .

Des questions se posent : pourquoi et comment les sources ou les puits dépendent-ils d’El Niño ? Pourquoi ces dépendances à court terme de la température sont-elles apparentes, mais les tendances à long terme de la température mondiale ne semblent pas correspondre dans le modèle ? En outre, il n’est pas évident de savoir si les fluctuations sont imputables aux absorptions ou aux émissions naturelles. Pour en savoir plus, nous devons introduire la dépendance à la température dans le modèle.

La concentration de CO2 est un indicateur de la température

Pourquoi la tendance indéniable à long terme de la température ne peut-elle pas être observée dans le modèle linéaire simple, qui montre clairement les dépendances à court terme de la température ? Pourquoi n’y a-t-il aucune tendance dans les émissions naturelles estimées, ce qui est impliqué par la loi de Henry pour les puits et les émissions océaniques ainsi que par la dépendance à la température de la photosynthèse ?

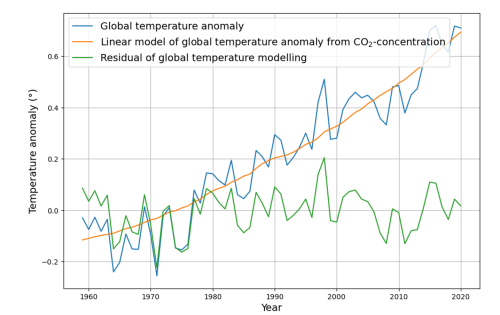

La réponse est liée au fait que la concentration de CO2 et l’anomalie de la température moyenne mondiale sont fortement corrélées. Nous ne prétendons pas à une causalité ni à une quelconque autre dépendance entre la concentration de CO2 et la température, dans un sens ou dans l’autre, mais reconnaissons simplement leur forte corrélation au cours des 65 dernières années.

Nous pouvons interpréter l’anomalie de la température mondiale comme la somme d’une fonction linéaire de la concentration de CO2 et d’une température résiduelle moyenne nulle sans tendance. Ceci est illustré par la figure 3.

Conséquences de l’indicateur de température du CO2

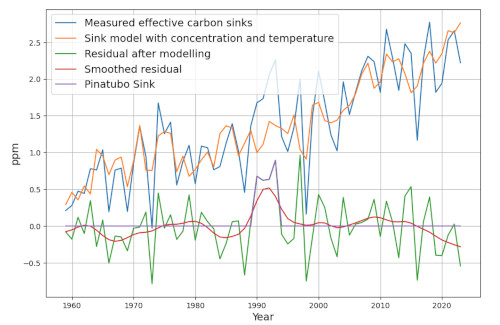

La température réelle est la somme de la température modélisée et de la température résiduelle. Par conséquent, étant donné que le modèle linéaire de puits de carbone dépend de la concentration en CO2, la dépendance de la partie de la température qui est une fonction linéaire de la concentration en CO2 est attribuée à la concentration en CO2 . Dans le cas de la dépendance à la température, nous ne pouvons donc nous attendre à voir qu’une dépendance à la température résiduelle, qui est une moyenne nulle et n’a pas de tendance. Cela correspond à l’observation de Roy Spencer selon laquelle une grande partie de la variabilité à court terme du puits de carbone s’explique par El Niño, qui est étroitement lié à la température résiduelle globale. Néanmoins, il s’agit d’une dépendance réelle à la température, masquée par la colinéarité de la concentration en CO2 et de la température, mais reconstituable au moyen de l’effet mesurable de la température résiduelle.

La figure 4 montre que la température résiduelle globale (surface de la mer) explique en effet une grande partie de la variabilité à court terme de l’effet de puits mesurable. Le résidu de puits lissé est désormais pour l’essentiel proche de 0, à l’exception de la période autour de l’éruption du Pinatubo (après 1990), qui constitue le signal non pris en compte le plus dominant après l’application du modèle étendu par la température.

Le coefficient d’effet de la température sur le puits annuel est de -2,9 ppm/°. Ce chiffre est assez élevé, étant donné que l’effet total du puits annuel, qui comprend à la fois la concentration et la température, est actuellement de 0,018*(420-280) ppm = 2,5 ppm. Cela implique également que l’augmentation de la température réduit l’effet du puits, ce qui signifie que l’augmentation des températures réduit les absorptions naturelles ou augmente les émissions naturelles (ou les deux).

Avant de tirer de fausses conclusions, il faut préciser que l’effet de la température sur le puits de carbone est annulé par l’effet de puits croissant dû à la concentration, pendant la période où la température et la concentration sont corrélées comme elles l’ont été au cours des 65 dernières années.

Lorsque l’effet de la température sur les puits est si important et négatif, nous sommes obligés de supposer que le taux d’absorption annuel « réel » lié à la concentration est de 4,36 %, soit considérablement plus élevé que les 1,83 % du modèle linéaire simple. (Les calculs exacts sont dans l’article original ). L’absorption plus élevée est compensée par les émissions dépendantes de la température, dont le niveau de base annuel (13,6 ppm) est également bien plus élevé que les 5,2 ppm du modèle linéaire simple. Ce modèle étendu reflète donc à la fois l’absorption descendante dans les océans froids ainsi que l’émission ascendante dans les océans chauds.

Une question importante est de savoir si nous avons une indication que ce taux d’absorption plutôt élevé peut être justifié par des mesures. En raison des essais nucléaires des années 1950, qui ont cessé en 1963, nous avons une impulsion d’émission de carbone identifiable proche de l’idéal qui a été étudiée en profondeur pendant plus de 40 ans. La concentration atmosphérique décroissante en carbone 14 (14𝐶) qui en résulte montre, sur une période de 30 ans, que les processus de puits d’absorption contribuant présentent une décroissance exponentielle non déformée d’une équation différentielle linéaire du premier ordre. Le temps de décroissance de la courbe de concentration résultante a été déterminé à 15 ans, ce qui implique un taux de descente annuel de 1/15≈6,7 %. Bien qu’une petite partie (< 0,5 %/an) de la réduction de la concentration en 14𝐶 dans l’atmosphère soit due à l’effet de dilution de l’augmentation de la concentration par les émissions anthropiques, cela confirme en effet qu’un taux d’absorption annuel de 4,36 % est plausible.

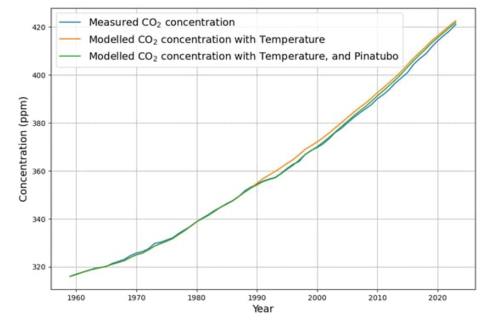

Reconstruction de la concentration de CO2 à partir du modèle de puits

La reconstruction du modèle de la série temporelle de concentration utilise désormais un terme de puits contenant la température ainsi que la concentration (équation 18 dans l’article). La reconstruction est effectuée en calculant la croissance de concentration modélisée à partir de la différence entre les émissions anthropiques et l’effet de puits modélisé. À partir d’une valeur de concentration initialement connue au début de la série temporelle, toutes les valeurs de concentration suivantes sont calculées de manière récursive en utilisant la croissance de concentration modélisée. Cette évaluation est présentée pour la reconstruction dans la figure 5.

La reconstruction ne s’écarte que vers 1990 en raison de l’absence de contribution de l’éruption du Pinatubo, mais suit précisément la forme de la courbe de concentration mesurée. Cela indique que le modèle utilisant la concentration et la température est mieux adapté à la reconstruction de la concentration de CO2 que le modèle simple de puits utilisant uniquement la concentration. Pour compenser les écarts après 1990, l’effet de puits dû au Pinatubo doit être pris en compte. Il est introduit comme un signal d’émission négatif, c’est-à-dire une impulsion de puits supplémentaire dans la modélisation récursive (graphique violet sur la figure 4).

Cela réduit considérablement les écarts du modèle par rapport à la concentration mesurée, comme le montre le graphique vert de la figure 5. La compréhension des processus qui façonnent la concentration s’en trouve améliorée. Néanmoins, le modèle surestime légèrement la concentration de CO2 après 2005. Il semble que si les puits naturels ont une tendance, il s’agit d’une tendance à l’augmentation de l’effet de puits au cours des dernières années plutôt qu’à la saturation.

Conséquences du modèle dépendant de la température

Le paramètre d’absorption dépendant de la concentration est en fait désormais plus de deux fois plus élevé que le paramètre d’absorption initial du modèle indépendant de la température, et l’augmentation de la température accroît les émissions naturelles. Lorsque la température est corrélée à la concentration de CO2, les deux tendances s’annulent et l’effet de puits total semble être invariant par rapport à la température. Le modèle étendu devient pertinent lorsque la température et la concentration en CO2 divergent.

Si la température augmente plus vite que ce que suggère la relation de substitution du CO2, on peut s’attendre à un effet de puits réduit, tandis qu’avec des températures inférieures à la valeur attendue de la relation de substitution du CO2, l’effet de puits augmentera. Nous nous intéressons donc aux situations où il n’y a pas d’émissions anthropiques contribuant à la concentration de CO2.

Un modèle informatique pour les données des carottes de glace de Vostok

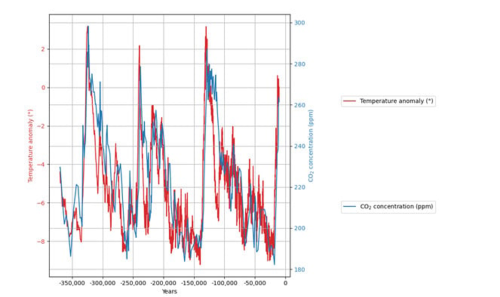

Les données des carottes de glace de Vostok offrent une vue de plus de 400 000 ans sur l’histoire du climat, avec plusieurs cycles entre les périodes glaciaires et les périodes chaudes.

La plupart des chercheurs s’accordent à dire que les données sur le CO2 sont en retard de plusieurs siècles sur les données sur la température. Une difficulté vient de la nécessité de mesurer le CO2 dans les bulles de gaz, alors que la température est déterminée à partir d’un proxy de deutérium dans la glace. Il existe donc une manière différente de déterminer l’âge des deux paramètres : pour le CO2 , il existe un « âge du gaz », tandis que la série de température est attribuée à un « âge glaciaire ». Il existe des estimations de l’âge de l’« âge glaciaire » par rapport à l’âge du gaz. Mais il existe une incertitude, c’est pourquoi nous nous attendons à ce qu’il soit nécessaire d’ajuster le décalage temporel entre les deux séries temporelles.

En 2005, plusieurs équipes ont tenté de fournir des modèles à partir des données de Vostok. Aucun résultat final clair n’a été obtenu. Il n’y avait même pas de consensus complet sur la question de la causalité entre la température et la concentration en CO2, bien que sept des huit équipes aient préféré que la température soit la cause des changements de concentration de CO2, plutôt que l’inverse.

Il est difficile d’évaluer la qualité de leur reconstruction du CO2 à partir des chiffres fournis, et aucune évaluation de la qualité statistique n’est donnée. D’après la description, on peut supposer que seule l’équipe proposant que le CO2 soit la cause des changements de température a utilisé un modèle similaire à celui utilisé pour étudier le climat actuel.

Prétraitement des ensembles de données Vostok

Pour pouvoir effectuer des calculs basés sur un modèle avec les deux ensembles de données, les données d’origine doivent être converties en ensembles de données échantillonnés de manière égale. Cela se fait au moyen d’une interpolation linéaire. L’intervalle d’échantillonnage est choisi à 100 ans, ce qui correspond approximativement à l’intervalle d’échantillonnage de l’ensemble de données de température. En outre, les ensembles de données doivent être inversés et le signe de l’axe du temps doit être défini sur des valeurs négatives. Les deux ensembles de données rééchantillonnés sont représentés superposés dans la figure 6.

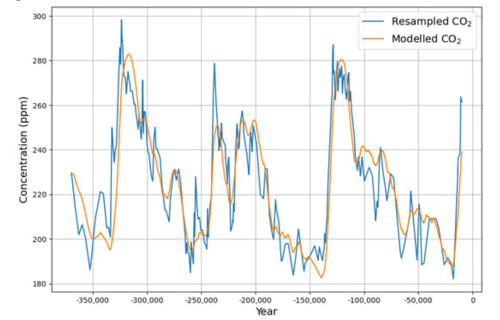

Modèle de données

En raison de la bonne qualité de modélisation du modèle de puits dépendant de la température pour les données actuelles d’émissions, de concentration et de température, nous utiliserons le même modèle basé sur le bilan massique du CO2 et la possible dépendance linéaire de la croissance du CO2 sur la concentration de CO2 et la température, mais évidemment sans aucune émission anthropique. De plus, l’unité de temps n’est plus l’année, mais le siècle.

Après avoir estimé les trois paramètres qui prédisent l’effet de puits, la dépendance à la concentration, la dépendance à la température et une constante au moyen des moindres carrés ordinaires, les données modélisées de CO2 sont reconstruites de manière récursive au moyen de ce modèle.

Données de CO2 reconstituées à partir de la température

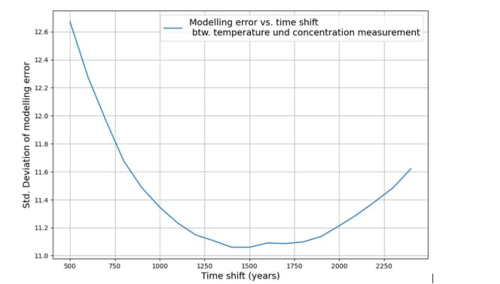

L’écart type de la différence entre les données de concentration en CO2 mesurées et reconstituées mesure la qualité de la reconstitution. Cet écart type est minimisé lorsque les données de température sont décalées de 1450 à 1500 ans dans le passé, comme le montre la figure 7.

Le modèle estimé correspondant aboutit à un effet de puits de carbone de 1,3 % de la concentration par siècle et à une augmentation des émissions naturelles de 0,18 ppm par siècle à partir d’une augmentation de température de 1 degré. Ces effets sont très faibles. Néanmoins, la reconstruction des données de CO2 à partir du modèle de puits étendu à la température semble assez remarquable, comme le montre la figure 8.

La qualité de la reconstruction et le minimum d’erreurs clairement établi en fonction du décalage temporel sont des arguments assez solides pour que les changements de température soient la cause des changements de concentration de CO2 plutôt que l’inverse. Mais même aujourd’hui, les données des carottes de glace sont utilisées pour justifier une sensibilité élevée au CO2 de 5 degrés ou plus.

Même si nous admettons provisoirement que le CO2 est responsable des changements de température, l’argument de la carotte de glace pose un gros problème. En effet, la concentration en CO2 des carottes de glace varie entre 200 et 280 ppm, c’est-à-dire que le facteur entre le maximum et le minimum est d’environ 1,4. Il est également vrai qu’avant l’industrialisation, la concentration était de 280 et aujourd’hui, avec une concentration de 420 ppm, le facteur est de 1,5 et le changement de température est d’environ 1,2 degré. Il est donc inconcevable que des changements de température aussi extrêmes que ceux observés entre les périodes glaciaires aient été causés par des changements de concentration en CO2 aussi faibles. L’argument de la haute sensibilité basé sur les carottes de glace est donc disqualifié.

Conclusions

L’incohérence apparente entre la sensibilité des effets de puits aux variations de température à court terme et l’invariance par rapport aux tendances de température a été résolue en identifiant la colinéarité entre les tendances de température et la concentration en CO2. Au cours des 65 dernières années, la corrélation entre la température et la concentration en CO2 a été très élevée. Par conséquent, toute dépendance à la tendance de température a été attribuée à la concentration en CO2 dans le modèle linéaire original. En évaluant les données mesurées avec un modèle, où la température résiduelle est ajoutée, la dépendance réelle à la température peut être mesurée. Par cette procédure, le modèle est étendu pour devenir véritablement dépendant de la température. Des recherches supplémentaires sont nécessaires pour valider les résultats du modèle étendu avec d’autres mesures.

Le modèle amélioré par la température reproduit également très bien les concentrations de CO2 des séries de données des carottes de glace de Vostok. Cela confirme également que dans les séries de données paléoclimatiques, la température est en avance sur la concentration de CO2.

Avec des données récentes, où il existe une forte corrélation entre la concentration de CO2 et la température, la dépendance de la tendance de la température est équilibrée ; par conséquent, nous devons accepter qu’actuellement les émissions anthropiques sont le principal facteur visible de la concentration atmosphérique de CO2, tandis que la température n’ajoute en réalité qu’une certaine variabilité moyenne nulle.

Tient au fait, qu’en pense le would-be prix Nobel J. Jouzel ?

Ceci dit, la solubilité du CO2 étant très dépendante de la température (manuels de chimie), il est parfaitement prévisible que l’océan froid le stocke sous forme dissoute pendant les glaciaires et que l’océan réchauffé le restitue à l’atmosphère lors des interglaciaires. Avec évidemment un temps de latence dû à la lenteur de l’homogénéisation de la masse océanique. Cela paraît une évidence crasse mais devant la mauvaise foi des réchauffistes (il y a des articles qui expliquaient que c’était faux) il fallait le démontrer, ce que fait cet article. On voyait déjà bien ce décalage de plusieurs siècles sur les courbes CO2-isotopes de l’oxygène mais nos yeux nous trompent, n’est-ce pas.

Quant à la denière phrase de la conclusion, elle déculotte proprement l’article foireux de Camille Veyres (voir un peu plus tôt sur le site de l’ACR) qui affirmait, sur la base de sophismes qualifiés de ”faits” (n°1, 2, 3, …) que l’augmentation dramatique récente du CO2 n’était pas dû à l’activité humaine mais tout à fait naturelle. Une ”activité naturelle” qui démarre exactement au moment de la révolution industrielle. Et qui est sans rapport avec l’augmentation ridicule des températures depuis qq décennies. Faut le faire.

Il est dangereux d’essayer d’attribuer la croissance de la concentration entièrement aux émissions naturelles, par exemple avec l’argument qu’elles sont tellement plus importantes que les émissions anthropogéniques, que les émissions antropogéniques sont « noyées » dans leur « bruit ».

Il est extrêmement important d’affirmer que le cycle du carbone biologique est nécessairement un puits de carbone statique, tant qu’il n’y a pas de catastrophes globales : https://klima-fakten.net/?p=8176&lang=en

Sinon, nous soutenons tous les ennemis de la vie qui veulent, par exemple, tuer les vaches et décimer les humains.

Traduit avec DeepL.com (version gratuite)

J’ai parcouru très vite toute l’étude, avant de sombrer, pour en venir à la conclusion.

En clair, si j’ai bien compris: La corrélation étroite de ces dernières années entre la concentration atmosphérique en CO2 et la température globale serait purement fortuite, puisque les données paléoclimatiques revisitées par cette étude confirment bien que la hausse (ou la baisse) des températures globales précèdent d’un certain temps de latence la hausse (ou la baisse) des concentrations en CO2 dans l’atmosphère.

Dans cette étude, je m’abstiens de dire quelle est l’influence de la concentration de CO2 sur la température moyenne. Le fait observé que l’augmentation de la température entraîne une concentration plus élevée de CO2 n’exclut pas a priori l’existence d’une causalité dans le sens inverse. Le modèle que j’ai présenté n’est donc pas en contradiction avec la possibilité qu’il y ait une sensibilité au CO2 de 1 à 2 °C en cas de doublement de la concentration. J’ai cependant décrit ailleurs que cette sensibilité est limitée à environ 0,5°C en raison de l’équation physique de transport du rayonnement (https://klima-fakten.net/?p=4898&lang=en). Et pour le cas particulier de l’Allemagne, j’ai pu démontrer statistiquement que la variabilité de la température est expliquée à 90% par les heures d’ensoleillement et que la concentration en CO2 ne joue aucun rôle significatif (https://klima-fakten.net/?p=10235&lang=en).

Traduit avec DeepL.com (version gratuite)

”pour le cas particulier de l’Allemagne, j’ai pu démontrer statistiquement que la variabilité de la température est expliquée à 90% par les heures d’ensoleillement et que la concentration en CO2 ne joue aucun rôle significatif”…

Gut gespielt !

Effectivement, il existe des études montrant que l’augmentation récente des températures est surtout liée à une diminution générale de la nébulosité. Pourquoi cette diminution ? Mystère.

Cela rejoint une évidence crasse : les jours nuageux il fait frais, les jours ensoleillés il fait chaud.

Tout cela me fait penser à cette épineuse question : « Qui fait l’oeuf ? C’est la poule. Et qui fait la poule, c’est l’oeuf. Est-ce que l’oeuf est le père de la poule ou la poule la mère de l’oeuf ? (Raymond Devos)

Pour la science c’est l’œuf en premier

Pour paraphraser Dawkins, avant on pensait qu’un oeuf c’était un truc pour faire des poules, maintenant, au contraire on pense que la poule c’est un truc pour faire des oeufs. Ce qui compte c’est d’alimenter le grand fleuve de nos genes.

J’aime bien Dawkins.

En complément, un article très complet sur WUWT qui confirme :

https://wattsupwiththat.com/2024/09/04/ockhams-view-of-cenozoic-co2/

Cliquer sur les renvois rouges pour la biblio associée, très complète.

J’aime bien le dernier couplet de l’article :

”As a general and unavoidable conclusion: the dogma that the radiative forcing of CO2 controls global mean surface air temperature should be set aside. The party’s over.”

La fête est bien terminée.

Merci beaucoup pour cette remarque.

J’ai beaucoup de respect pour Pat Frank. Il a réussi à reproduire les résultats des modèles climatiques globaux complexes avec une approche très simple, pour ainsi les démythifier.

J’attends avec impatience cette lecture intéressante.

Allez, pour finir :

Le Pr Raoult vient de sortir un nouveau livre (”Homo chaoticus”), voir l’interview sur France Soir, qui aborde trois points essentiels.

Le premier est bien sûr la rétractation récente de l’article du Lancet sur la dangerosité de l’hydroxychloroquine, article qui est un véritable scandale scientifique. Sans doute au nom de l’objectivité, les auteurs statisticiens ont mélangé et trituré les données raisonnables et les données totalement foireuses sur ce médicament. Il a pourtant été prescrit depuis des lustres à des doses faibles sans dommage pour soigner diverses affections. Pendant l’épisode Covid, certains ”médecins” ont administré aux patients des doses qui auraient tué un cheval et qui ont donc tué leur malade, sans pour autant que ces ”médecins” finissent au tribunal. Un comprimé d’aspirine soigne le mal de tête, trois tubes vous conduisent à la morgue. Selon le Pr Raoult, l’éphémère ministre de la santé, François Braun avait fait sa thèse de médecine précisément sur l’hydroxychloroquine, en déterminant les doses admissibles, faibles, conformes à la pratique déjà établie. Devenu ministre, son cerveau politique s’est déconnecté de la réalité scientifique pour condamner les traitements et forcer à la ”vaccination” ARNm. Et là nous entrons dans le deuxième point.

L’homo chaoticus est précisément cet individu dont le cerveau est cloisonné par une ou des parois étanches. Ce qui est vrai dans une case ne l’est pas dans l’autre (des mondes parallèles en quelque sorte), sans pour autant que cela soulève une quelconque conscience de la contradiction chez le bonhomme. Ou alors il la met dans la poche avec le mouchoir par dessus par intérêt, allez savoir. On peut voir une analogie avec les réchauffistes, que ce soit Monsieur tout le monde ou des scientifiques réputés : les données non conformes sont rejetées, le scientifique convaincu de ses thèses allant jusqu’à ”démontrer” que c’est faux (cf Jouzel qui avait bien remarqué le décalages des courbes CO2-isotopes mais avait refusé d’en tirer les conclusions). A notre petite échelle, nous en avons eu un très bon exemple sur le site de l’ACR où a sévi un temps notre ”transgenre” Brionne/MLA qui ne voyait dans les articles scientifiques que les courbes qui montent. Les bons articles sont ceux où ça monte.

Le troisième point est plus inquiétant encore. Depuis que les principales revues scientifiques ont été cornaquées par les puissances financières (Elsevier, Springer, etc.), c’est à dire les fonds de pension américains, la publication scientifique, ansi que le processus de peer-reviewing qui en est en principe un garant de qualité, sont pilotés par des éditeurs qui sont de plus en plus des gens qui n’ont rien publié, des sortes de financiers administratifs, qui décident de quelle science est la bonne (celle qui va faire monter l’index de la revue, pour assurer les abonnements). En cas de problème, eh bien on va choisir les bons reviewers pour faire disparaître le mauvais article. Voir les cas Richet et Alimonti sur le climat. Certains scientifiques sont complices, pour des raisons qu’il faudrait analyser en détail (clin d’oeil). C’est très grave, à tel point qu’une tendance se dessine un peu partout pour que la publication scientifique revienne à l’académie, pas aux financiers, via des revues purement internet, bénévoles et qui ne coûtent quasi rien, accessibles gratuitement et non protégées par des abonnements aux prix monstrueux qui coulent les bibliothèques universitaires et bloquent le quidam simplement curieux de la science.

Tout ceci est très déprimant. Mais la science s’en sortira car elle est basée sur les faits. Et, comme disait Lénine, je crois, les faits sont têtus.

Les Pr Raoult et Brouqui ont publié fin juillet une étude peer reviewed pubiée dans la revue Acta Scientific Microbiology portant sur plus de 1200 patients ayant contracté le Covid, qui démontre de manière irréfutable les effets positifs de l’hydroxychloroquine sur cette maladie.

On attend d’une minute à l’autre la rétractation de tous les articles méprisants, sarcastiques ou injurieux de pseudo scientifiques ou de journalistes-vulgarisateurs totalement ignorants du sujet, sans oublier les quolibets de l’ineffable Véran, qui ont hurlé avec les loups pour casser les reins du Pr Raoult et de ses collaborateurs.

https://actascientific.com/ASMI/pdf/ASMI-07-1413.pdf

L’essai britannique Recovery montre l’absence d’effet bénéfique de l’hydroxychloroquine chez les patients déjà hospitalisés.

L’essai international Solidarity confirme l’inefficacité de l’hydroxychloroquine également chez les patients hospitalisés.

En fait pour que ça marche faut juste être bien portant…

N’importe quoi !

Le Pr Raoult a bien insisté sur le fait que le traitement devait être administré le plus tôt possible. Ensuite (hospitalisation), il est trop tard. Il faut couper l’herbe sous le pied à la multiplication de la spike.

Les deux études que vous citez ne font que renforcer ce que je dis, la science (enfin, une certaine science) est pourrie quelque part, soit par intention, soit par bêtise.

”pour que ça marche faut juste être bien portant”… Ridicule.

« L’essai britannique Recovery »… « L’essai international Solidarity »

Merci pour ce moment, continuez à nous faire rire…

Deux études, c’est infinitésimal pour « enterrer » définitivement l’hydroxychloroquine.

Je vous conseille de lire:

« HCQ for COVID-19: real-time meta analysis of 413 studies »

Sur https://c19hcq.org/meta.html

Peut être vos certitudes seront-elles un tant soit peu ébranlées et finiront par vous faire admettre que la recherche et la découverte de deux molécules (HCQ et Ivermectine) permettant de sauver des malades dans l’attente d’un vaccin étaient une alternative urgente à ce dernier, surtout après que les statistiques anglaises récemment publiées aient démontré que le vaccin n’a protégé personne ni contre la contamination, ni contre la transmission du virus, ni même contre les formes graves de la maladie !

Bravo, Professeur, pour cette brillante démonstration de l’inefficacité de l’hydroxychloroquine contre le covid-19 !

Mais, on peut encore aller plus loin dans votre sens.

Une autre étude clinique, moins connue, randomisée et en double aveugle, que vous n’avez pas signalée est encore plus probante.

Les morts décédés du covid 19 traités (post mortem) avec des doses massives d’hydroxychloroquine ne sont pas plus ressuscités que les morts non bénéficiaires de ce traitement.

Conclusion logique indiscutable, qui complète et confirme vos judicieuses observations:

L’hydroxychloroquine est sans bénéfice aucun dans le traitement du Covid, quel que soit le stade de la maladie.

Merci, Professeur

Sans minimiser les fraudes, il y en a toujours eu, il ne faut rien exagérer non plus.

Et puisque vous aimez les faits je souligne que c’est la revue Lancet elle même qui a supprimé l’article.

Ce qui en soi n’a rien de nouveau. C’est déjà arrivé dans le passé. Et cela arrivera encore.

OK, mais le ministre Véran avait, dans un réflexe quasi pavlovien, saisi au vol la publication de cet article-hoax comme prétexte pour interdire toute utilisation de l’HCQ y compris dans des protocoles expérimentaux. En toute logique, une fois le lièvre de la fraude levé, il aurait du suspendre immédiatement cette interdiction.

Il ne l’a pas fait…

Vous avez raison. Mais pas la suite d’autres études ont montrées l’inefficacité de l’hydroxychloroquine.

@Pr Sheldon Cooper

Avez-vous seulement lu l’étude publiée peer reviewed en juillet dernier par le Pr Raoult et l’un de ses collaborateurs sur un panel de plus de 1200 patients atteints du Covid ?

Elle est inattaquable !

https://actascientific.com/ASMI/pdf/ASMI-07-1413.pdf

Que pensez-vous des stats anglaises sur les résultats de la vaccination contre le Covid au Royaume Uni ?

Désolé pour vous si vous vous êtes fait vacciner.

1. L’article en question du Lancet, qui met sur un pied d’égalité le raisonnable et le grand n’importe quoi, n’aurait JAMAIS dû être publié si le reviewing était sérieux

2. L’éditeur supprime l’article contraint principalement par le scandale, car il le fait bien tardivement (voir le point 1 ci-dessus), ce qui laisse des doutes sur sa réelle volonté

3. Le fait que ce soit l’éditeur qui supprime l’article prouve quoi ? Qui d’autre peut le supprimer ? Et de toute façon, il le fait tardivement et contraint par les études nouvelles qui ridiculisent l’article initial.

4. Cela arrivera encore, certes, mais la question n’est pas là. Le problème évoqué est la dérive générale de l’édition scientifique, prisonnière du fric et de plus en plus gérée par ce qu’il faut appeler par leur vrai nom, des commerciaux. Les universitaires associés à l’édition ressemblent de plus en plus à des hommes de paille, des idiots utiles en quelque sorte. La dérive ne fait que commencer, elle reste encore peu perceptible pour beaucoup, d’où le nombre encore élevé d’idiots utiles. Mais cette dérive est bien visible dans les boites mel des chercheurs qui sont harcelés (j’en sais qqch) par des propositions de collaboration à l’édition payante qui multiplie les revues nouvelles. Des propositions, bien entendu, émanant à chaque fois de scientifiques (enfin, j’espère), les hommes de paille (cf ci-dessus). Certains paraissent rémunérés par ces revues.

@Serge Ferry,

Vous remarquerez que c’est le journal « France-Soir » qui a été le premier au monde à débusquer l’étude-pipeau de The Lancet. France-Soir, considéré en France comme un journal complotiste, a été salué par de très nombreux média de la planète pour cet exploit.

Ce n’est pas tous les jours que The Lancet est ridiculisé pour complotisme par des complotistes.

Ces commentaires sont hors sujet. Désormais, je supprimerai toute commentaire sur le Pr Raoult et le COVID

J’ai moi-même vécu ce que vous décrivez. Ni Nature ni AGU n’étaient prêts à publier les publications de mon co-auteur et de moi-même.

Heureusement, il existe désormais des alternatives comme MDPI ou d’autres, qui ont désormais un niveau comparable (pour mes publications, j’ai choisi de publier les commentaires des revues par souci de transparence).

Même le service météorologique allemand y publie désormais.

Nous constatons également dans le domaine scientifique que « l’Occident collectif » perd sa domination sur le monde et qu’un monde multipolaire est en train de naître.

Je connais le sérieux de la revue Nature. Je penche plus pour l’hypothèse que vos publications n’étaient pas à la hauteur.

Il existe une hiérarchie dans les revues. Et je ne vois pas de perte de domination de l’occident sur le plan scientifique.

@Joachim Dengler5 septembre 2024 at 22 h 59 min

Vous pouvez pas dire à qui vous répondez ?

”j’ai choisi de publier les commentaires des revues par souci de transparence”…

Vous avez raison, autrefois, dans le Bulletin de la Société Géologique de France, les articles étaient suivis d’une rubrique ”Questions et réponses”, aujourd’hui disparue.

Je verrais bien que soit publiés à la fin des articles un condensé des remarques de l’éditeur ainsi que les réponses (argumentées) apportées par le ou les auteurs. On y gagnerait en transparence, les lecteurs pourraient juger du dessous des cartes.

Je souhaite commenter le deuxième paragraphe du chapitre intitulé ; » Un modèle informatique pour les données des carottes de glace de Vostok « .

Je suis allé sept fois en Antarctique entre 1990 et 2010 sur un programme scientifique en collaboration avec une équipe italienne et plusieurs équipes américaines. Je suis allé à Dome où le programme EPICA était en cours.

J’ai publié de plusieurs articles sur l’Antarctique dans des revues de haut niveau. Ces articles sont disponibles sur le site Academia et je constate que mes articles sont toujours lus et cités par de nombreux auteurs.

Je prétends donc savoir de quoi je parle, mais je reviendrai sur ce point plus tard.

Je ne comprends pas ce concept » d’âge du gaz » comparé à un » âge glaciaire » sous prétexte que le procédé physique d’estimation de l’un et de l’autre serait différent.

la datation des carottes de glace se fait au vu de la teinte des couches de glace qui dépend de la densité des poussières. Il y a bien une différence de cette densité sur le cycle annuel parce le centre des perturbations cycloniques au nombre de trois ou cinq qui tournent autour de l’Antarctique suivent la limite entre la glace et l’océan. En conséquence les perturbations sont proches du continent en été et éloignées en hiver, ce qui fait que l’air est plus propre en hiver qu’en été. Naturellement il y a des erreurs de datation par cette méthode, mais on peut les corriger pour des dates relativement récentes à partir des traces d’expérimentation de bombes nucléaires ou d’éruptions volcaniques dont on retrouve les traces dans la glace.

Le piégeage de l’air dans la glace se fait en surface. Sur le plateau à Vostok ou à Dome C il y a une couche intermédiaire d’une quinzaine de mètres d’épaisseur entre l »atmosphère et la glace. Ce n’est pas de la neige, mais de la glace sous forme de grains avec de l’air. Cette couche se tasse progressivement sous son propre poids et devient de la glace entre dix et quinze mètres. En surface il y a une couche fine qui empêche l’air de partir. Ce processus exclut l’idée que l’air puisse avoir un âge différent de celui de la glace dans les carottes.

Un article de Humlum publié ici il y a quelque temps parvient aux mêmes conclusions que cet article.

Je me suis fait insulter gravement par un directeur de recherche du CNRS de Grenoble très proche de la communauté EPICA et du GIEC quand j’ai osé poser la question du retard du taux de CO2 par rapport à l’augmentation de la température.

Il me paraît clair que cette histoire d’âge du gaz et d’âge de la glace est une invention destinée à masquer le fait que les données de température et de CO2 obtenues dans les carottes de glace aussi bien à Vostok qu’à Dome C qui sont excellentes et indiscutables ne corroborent pas le concept d’effet de serre prôné par le GIEC.

Il se trouve que le laboratoire de glaciologie de Grenoble a développé un modèle de glace pour l’antarctique sous l’impulsion à l’époque de son directeur Louis Liboutry. Celui-ci avait un concept proche de celui d’un autrichien nommé Hutter qui faisait l’hypothèse de viscoplasticité de la glace. Ce concept ne résiste pas à l’examen de la physique du problème, mais malheureusement il s’est imposé malgré plusieurs obstacles scientifiquement insurmontables.

Les deux les plus fondamentaux sont le gradient de température de l’ordre de 40°C entre la base et le sommet de l’Antarctique, ce qui est physiquement impossible, et l’idée que le bilan de masse se fait en surface, ce qui a pour conséquence qu’il n’y a pas de fonte à la base de l’Antarctique alors que l’on sait maintenant qu’il y a en antarctique de nombreux lacs sous glaciaires dont Vostok est un très bel exemple. On sait aussi que l’Antarctique de l’ouest a les pieds dans l’eau.

Au Dome C la glace a environ 3000 mètres d »épaisseur. En gros cela représente un million d’années du climat de la Terre. On sait que l’Antarctique existe depuis plus de 30 millions d’année. Si on suppose que l’Antarctique fond à la base, on n’a aucun problème pour expliquer que les trois kilomètres de glace à Dome C actuels ne représentent que le dernier million d’années de climat de la Terre.

La seule question scientifique à se poser est de savoir si la glace peut fondre à la base de l’Antarctique à une température de -50°C. La réponse est oui parce que c’est ce que prouve un diagramme tri-point de l’eau complet qui montre que la surface d’équilibre entre la phase liquide et la phase glace de l’eau existe entre -60°C et 0°C.

Messieurs Hutter et Liboutry étaient tous deux des géophysiciens, sans doute de talent, mais ils n’avaient aucune connaissance en thermodynamique et étaient incapables de comprendre le diagramme tri-point de l’eau.

Ce n’est pas une question de fraude, mais il y a des scientifiques qui sont qualifiés d’experts dans des domaines qu’ils ne comprennent que très peu parce qu’ils n’ont pas les connaissances en physique suffisantes.

Ces scientifiques acceptent facilement les consensus en vogue, ce qui est dramatique dans le domaine qui nous intéresse tous.

PETTRE8 septembre 2024 at 16 h 11 min

« » » » » » »Je me suis fait insulter gravement par un directeur de recherche du CNRS de Grenoble très proche de la communauté EPICA et du GIEC « » » » » »

Des noms SVP

Il s’agit de Gerhard Krinner.

Paul Pettré

Le diagramme tri-point de l’eau c’est au programme de la première ou deuxième année de sciences. Je suis surpris que des géophysiciens avec un doctorat ne le connaisse pas.

C’est parce qu’en général les géophysiciens ne connaissent que le diagramme tri-point de l’eau tel que celui qu’on trouve sur Wikipédia. Ce diagramme suppose qu’entre -60°C et 0°C les courbes d’équilibre entre phase liquide et phase glace d’une part, et phase liquide et phase vapeur d’autre part sont confondues.

Cependant, si on se réfère au chapitre 8.3 SATURATION, MELTING, AND THE

CLAUSIUS-CLAPEYRON EQUATION du livre The Ceaseless Wind an introduction to the

theory of atmospheric motion de John A. Dutton, McGRAW-HILL, 1976, et au chapitre III.3

– THERMODYNAMIQUE DE L’EAU ATMOSPHERIQUE du livre du Professeur Paul

Queney, ÉLÉMENTS DE MÉTÉOROLOGIE, Masson, 1974, on voit que ces auteurs mettent en évidence la différence des courbes d’équilibre entre d’une part les phases glace et liquide, et d’autre part liquide et vapeur d’eau pour des températures inférieures à la température de fusion de H20, c’est-à-dire 0°C jusqu »à -60°C. Á de rares exceptions près dans la littérature, les auteurs ignorent cet écart entre les deux courbes.

Les météorologistes connaissent cette question parce qu’elle est très importante en physique des nuages.

Un point très important si on lit correctement ce diagramme tri-point de l’eau est que la glace ne sublime pas sauf au voisinage de 0°C.

L’autre point très important est que la température de fonte de la glace, c’est à dire le changement de phase de la glace vers l’eau liquide est de l’ordre de -60°C et non 0°C comme le pensent beaucoup de scientifiques.

Paul Pettré

Pouvez-vous expliciter votre dernière phrase, SVP ? J’ai de la peine à comprendre…

Bonjour Jack,

Je vous remercie pour votre question car c’est un point fondamental.

Ce qui est en question c’est la définition du point triple dans le diagramme tri-point.

Le point triple est le point auquel les trois phases (liquide, solide et vapeur) du corps étudié sont en équilibre thermodynamique. Le diagramme tri-point donne les valeurs de la température et de la tension saturante du point triple.

La température du point triple pour l’eau est obtenu expérimentalement ; on place de l’eau liquide, de la glace et de l’air dans un caisson fermé. On fait le vide dans le caisson de manière à ce que l’espace libre soit saturé en vapeur d’eau. A l’équilibre thermodynamique la température mesurée dans le caisson est celle du point-triple, soit 0,1°C.

En France les physiciens désignent le point-triple par point de fusion. Je présume que ce terme a été choisi parce qu’en métallurgie, si on veut obtenir des alliages composés de plusieurs corps purs il faut amener l’ensemble à la température de fusion la plus élevée.

En français le mot fusion prête à confusion car il est proche du mot fonte et désigne à peu près la même chose, mais ce que montre un diagramme tri-point correct, c’est que la glace peut » fondre « , c’est à dire passer de la phase solide à la phase liquide à partir de -60°C.

Donc la » température de fonte » de la glace est -60°C et la » température de fusion » désigne la température d’équilibre des phases solide, liquide et

vapeur, ce qui est fondamentalement différent.

Ce qui est important à comprendre, c’est que l’Antarctique est un système en équilibre thermodynamique, ce qui a pour principale conséquence que la température de la glace est isotherme. Même si la température de la glace est -50°C à la base de l’Antarctique, elle peut fondre pour peu qu’il y ait une lame d’air suffisante.

J’ajoute que puisque la densité de l’eau est plus élevée que celle de la glace, en cas de fonte de la glace la lame d’air augmente de volume et non l’inverse. Donc une fois le processus engagé rien ne peut l’arrêter.

C’est précisément le cas à Vostok où il y a un lac sous-glaciaire. Récemment les russes ont percé la voute surplombant le lac et ont mesuré la température de l’air à -2°C. Le système thermodynamique du lac est fermé, il est en équilibre et composé des trois phases de l’eau.

Cette température est proche de celle du point-triple et l’écart peut être attribué à l’imperfection du système. Il est possible que la vapeur ne soit pas à saturation.

Des mesures de la température de l’air dans les trous de carottage ont été effectués de manière systématiques. Les résultats montrent que à la base des trous on trouve toujours une température très proche de 0°C, ce qui confirme l’hypothèse thermodynamique.

Plus généralement il faut comprendre que l’Antarctique fond en permanence à sa base à un taux très faible qui est compensé par l’accumulation qui se fait au sommet.

Paul Pettré

Je suis très surpris du changement de la glace vers l’eau liquide à -60°C.

En effet, vous avez raison, -60°C est la température limite à laquelle la tension saturante est nulle, donc à -60°C il ne peut pas y avoir de changement de phase de la glace vers l’eau liquide.

Paul Pettré

Donc aucune chance de passer de la phase solide à la phase liquide à partir de -60°C.

@Pettre

Je suis très heureux et honoré que vous ayez écrit ce commentaire détaillé. Je suis profane en ce qui concerne les détails des carottes de glace, c’est pourquoi j’ai dû accepter les données telles que je les ai trouvées auprès des sources citées. Comme je ne connais rien aux processus qui sont à la base de la « période gazeuse » ou de la « période glaciaire » indiquée, j’ai intégré un paramètre de décalage temporel dans la procédure afin de déterminer automatiquement le décalage temporel optimal entre les changements de température et les changements de concentration de CO2. Il en résulte une question passionnante pour vous : en supposant que « l’ère gazeuse » et « l’ère glaciaire » soient identiques (c’est ainsi que je vous ai compris), est-il plausible, selon vous, que la concentration de CO2 suive la température avec un retard d’environ 1400 ans ?

Traduit avec DeepL.com (version gratuite)

J’ajoute pour clore le débat sur le diagramme tri-point de l’eau avec messieurs Sommer, Jack et Cooper que la question scientifique pertinente à se poser est de savoir si on observe dans la nature de l’eau liquide à des températures inférieures à 0°C et si l’on est capable de reproduire ce phénomène en laboratoire.

La réponse est oui : en français on désigne l’eau liquide à une température inférieure à 0°C par le terme » surfondue » et en anglais par » supercool « .

Deux épisodes de nuages d’eau liquide à une température de l’ordre de -40°C ont été observés à Dome C en Antarctique. Ces nuages ont été parfaitement documentés par radio-sondages et de nombreux instruments satellitaires.

Plusieurs équipes ont obtenu de l’eau surfondue jusqu’à des températures de l’ordre de -50°C.

La conclusion est facile à tirer : le diagramme tri-point de Wikipédia n’explique pas la possibilité de l’existence d’eau surfondue à des températures négatives entre 0°C et -60°C alors que les diagrammes tri-point de Dutton et Queney le font. Donc le diagramme de Wikipédia est erroné pour cette gamme de températures et les diagrammes de Dutton et Queney sont corrects.

Certains scientifiques feraient bien de réexaminer en détail certains de leurs concepts au vu de diagrammes tri-point de l’eau corrects.

Paul Pettré

« » » » » »la question scientifique pertinente à se poser est de savoir si on observe dans la nature de l’eau liquide à des températures inférieures à 0°C » » » » » » » »

Si je me souviens bien , l’eau de mer ne gèle qu’à moins deux degrés C

Mais Monsieur Pettré nous pose des questions de plus en plus salées

L’eau de mer n’est pas un corps pur justement parce qu’elle est salée.

Le diagramme tri-point de l’eau concerne le corps pur H2O.

Naturellement dans la nature on ne trouve pas de l’eau à l’état parfaitement pur, mais de l’eau suffisamment pure pour que son comportement soit proche de celui théorique décrit par le diagramme tri-point. Ce n’est pas le cas de l’eau de mer, mais celui d’un lac de montagne par exemple.

Paul Pettré

Je vous invite à lire l’article de Wiki sur la surfusion. Plutôt que tirer des conclusions erronées

Justement l’article auquel vous faites allusion décrit la manière expérimentale pour obtenir de l’eau surfondue en laboratoire.

Non seulement cela ne contredit pas ce que je dis, mais prouve au contraire qu’il est possible d’obtenir de l’eau surfondue en laboratoire.

Désolé de me répéter : dans le diagramme tri-point de Wiki, la phase eau liquide surfondue n’existe pas parce que pour les températures comprises entre 0°C et -60°C le seul changement de phase possible est de la glace vers la vapeur d’eau.

Si on peut produire de l’eau surfondue en laboratoire, il faut bien qu’il y ait un changement de phase qui se produise à des températures comprises entre -0°C et -60°C et ce, soit de la glace vers l’eau liquide, soit de la vapeur d’eau vers l’eau liquide.

Dans un nuage ces deux changements de phases sont possibles à des températures comprises entre 0°C et -60°C.

Il n’y a absolument rien d’erroné dans ce que je dis.

Paul Pettré

Vous avez tout lu ? De manière théorique la surfusion pourrait atteindre -48°C.

En pratique le record est de 42,55°C. On est assez loin de vos -60°C

Et alors ?

Donc vous êtes dans l’erreur avec vos -60°C.

Une fois encore Monsieur Cooper ne fait que confirmer ce que je dis.

La température limite de -60°C est celle pour laquelle la tension saturante est nulle comme le montre le diagramme de phase Wikipédia : https://fr.wikipedia.org/wiki/Diagramme_de_phase#/media/Fichier:Diagramme_de_phases_de_l'eau.svg.

Que sur le plan expérimental on ne puisse pas atteindre cette valeur, cela n’a rien d’étonnant.

Si le record expérimental est de -42,55°C Monsieur Cooper nous dira où il trouve l’espace de phase de l’eau liquide dans le diagramme Wikipédia dans la partie située sous le point triple. Il devrait y avoir une zone verte entre la zone bleue de la glace et la zone marron qui désigne la vapeur d’eau si le diagramme était correct.

Paul Pettré

Les calculs théoriques disent -48°C. Je pense que vous interprétez mal le diagramme.

Le diagramme des phases que je vous ai communiqué est assez facile à lire.

En ordonnée vous avez la pression saturante (aujourd’hui on dit tension saturante) donnée en Pascal à gauche et en bar à droite. L’abscisse est donnée en degrés Celsius en bas et en degrés Kelvin en Haut.

L’abscisse se trouve à 1 Pa qui est une valeur très faible de la pression proche de zéro.

Je vous rappelle que la pression atmosphérique standard à l’altitude 0 km géopotentiel est 1013 mbar (on dit aujourd’hui 1013 hPa), soit 101300 Pascal.

Je me réfère à la courbe noire qui passe par le point triple, le point d’ébullition et le point critique. C’est une courbe d’équilibre thermodynamique que l’on obtient de manière théorique. Pour obtenir cette courbe, le Professeur Paul Queney a utilisé les formules de Goff et Gratch qui ont été retenues par l’Organisation Mondiale de la Météorologie (OMM).

Sur le diagramme de phases cette courbe noire coupe l’axe des abscisse à -60°C ou 210°K.

L’auteur de ce diagramme a forcément obtenu cette courbe de manière théorique en utilisant peut-être d’autres formules que celles de Goff et Gratch, mais sa courbe est cohérente avec ce que je dis.

Le Professeur John A. Dutton n’utilise pas les formules de Goff et Gratch, mais il obtient le même résultat que le professeur Queney, c’est à dire que pour des températures situées entre 210 K et 273,16 K les courbes d’équilibre de phases entre la glace et l’eau liquide d’une part, et l’eau liquide et la vapeur d’eau d’autre part, ne sont pas confondues, ce qui a pour conséquence que l’on peut trouver de l’eau liquide dite surfondue à ces températures.

Contrairement à ce que vous pensez je suis plus à même que vous d’interpréter un diagramme des phases.

Paul Pettré

Si je le bien pour avoir cette température il faut une pression de 1 Pa. Pour avoir vos -60°C.

Effectivement peut être que dans l’espace c’est possible. Mais pas sur Terre.

Vous commettez l’erreur hyper-classique des gens qui ne savent pas lire un diagramme de phases.

J’ai bien écrit que l’ordonnée représente la » pression saturante » qui n’a absolument rien à voir avec la pression atmosphérique. Précisément aujourd’hui on parle de tension saturante parce que les physiciens ont compris que le terme » pression » induisait les gens en erreur. Simplement la tension saturante est exprimée dans la même unité que la pression atmosphérique.

Mais puisque vous aimez Wikipédia je vous recommande l’article intitulé : Pression de vapeur saturante de l’eau « , dans lequel vous trouverez la définition suivante : » La pression de vapeur saturante de l’eau est la pression à laquelle la vapeur d’eau est en équilibre thermodynamique avec son état condensé. « .

Vu votre niveau scientifique, Je crois que le mieux que vous avez à faire est d’arrêter la discussion et à l’avenir de cesser d’intervenir sur ce site même si on est bien d’accord que le ridicule ne tue pas et que vous avez le droit d’exprimer vos niaiseries.

Paul Pettré

Je comprends mieux pourquoi vous avez énervé un directeur de recherche du CNRS. au moins vous m’avez bien fait rire avec vos -60°C…

« » » » » » » » » » » » » »Contrairement à ce que vous pensez je suis plus à même que vous d’interpréter un diagramme des phases. » » » » » » » » » » » » » » » » » » » » » » » » »

A la niche Monsieur Cooper

« Dans un nuage ces deux changements de phases sont possibles à des températures comprises entre 0°C et -60°C. » Ce qui est faux. Voilà c’est tout. Pour le moment.

J’attends vos explications Monsieur Cooper.

Paul Pettré

Je vais essayer de vous expliquer cela.

1-« Les géophysiciens ne connaissent que le diagramme tri-point de l’eau tel que celui qu’on trouve sur Wikipédia » Qu’en savez vous ? Ou sont vos preuves ? Tel que vous le dites c’est juste une affirmation.

2-« La seule question scientifique à se poser est de savoir si la glace peut fondre à la base de l’Antarctique à une température de -50°C. » Non sur Terre la glace ne peut pas fondre à -50°C.

3-Il y a des scientifiques qui sont qualifiés d’experts dans des domaines qu’ils ne comprennent que très peu parce qu’ils n’ont pas les connaissances en physique suffisantes. Toujours sympa le dénigrement des collègues. surtout sans preuves. C’est sûr que c’est plus facile que de remettre en cause. Et si c’était vous qui vous trompiez ?

Je continue ? J’ajouterai que bien qu’abonné à de nombreuses revues je n’en ai pas trouvé d’articles de recherche à l’appui de vos affirmations. Néanmoins étant un scientifique j’admets que je peux me tromper. Une référence de votre part illustrant vos propos me conduirait à admettre que c’est moi qui me suis trompé.

1. Les premiers modèles numériques de calottes glaciaires ont été développés par des géophysiciens qui ont utilisés des techniques adaptées à leur domaine (voir l’article de K. Hutter, 1982, Mathematical Foundation of Ice Sheet and Ice Shelf Dynamics. A Physicist’s View, J ; Geophys. Astrophys. Fluid Dynamics, 21, 201-224. Extrait du livre : Free Boundary Problems : Theory and Applications).

Pour obtenir une certaine plasticité de la glace, les auteurs de ces modèles devaient faire une hypothèse sur le champ de température dans la calotte glaciaire qui supposait un gradient de température suivant la verticale qui n’est pas compatible avec les lois de la thermodynamique.

Vous pouvez aussi consulter le livre de Hutter et Wang intitulé Fluid and Thermodynamics à l’adresse suivante : https://books.google.fr/books?id=ngpkDAAAQBAJ&hl=fr&source=gbs_slider_cls_metadata_7_mylibrary

Vous pouvez aussi trouver en bibliothèque le livre de Louis Lliboutry intitulé : Physique de base pour biologistes, médecins, géologues, Paris, Masson, 1959 (réimpr. 1963), 421 p.

Vous aurez la preuve que ces deux auteurs ne comprennent pas les lois de la thermodynamique qui permettent d’obtenir un diagramme des phases correct.

2. Je vous recommande la lecture de l’article intitulé : Reversible Structural Transformations in supercooled liquid water from 135 to 245 K à l’adresse : https://www.science.org/doi/10.1126/science.abb7542

Le dispositif expérimental consiste justement à faire fondre la glace à des températures comprise entre -138°C et -28°C. Ces expérience ont lieu dans un laboratoire qui se trouve sur Terre et pas dans l’espace.

3. Je dis simplement que dans les cursus scientifiques l’étude de la thermodynamique n’est pas obligatoire, or c’est un domaine de la physique qui est difficile à comprendre. Vous vous prétendez physicien, vous l’êtes peut-être, mais d’après ce que je lis de vous il est assez clair que vous ne comprenez rien à la thermodynamique et que par conséquent vous n’avez aucune notion qui vous permette de comprendre ce qu’est en physique l’espace des phases d’un corps pur. Vous n’êtes pas le seul scientifique dans ce cas.

Faites une recherche google avec la phrase » lacs sous glaciaires en Antarctique « , et une autre avec » fleuve sous-glaciaire en Antarctique » et ensuite on pourra rediscuter pour savoir si vous vous trompez ou pas.

Paul Pettré

1- Basé sur 2 personnes vous en faites une généralité ?

2- En laboratoire. Pas en pleine mer.

3- Alors c’est que ça fait longtemps que vous n’avez pas vu de cursus scientifique.

C’est obligatoire dès la première année en licence de physique et de chime.

Sinon pour le lac Vostok : L’eau du lac Vostok reste liquide grâce au flux géothermique, à la pression et à l’isolation par l’épaisse couverture de glace. Il se carctérise par une température basse (−3 °C), pression élevée, environ 360 bars, absence de lumière, grande quantité de gaz dissous (milieu très oxygéné

Vous avez bêtement lu l’article de Wikipédia consacré au lac Vostok.

Mais cet article est très mauvais et truffé d’erreurs grossières.

En particulier c’est quoi cette pression de 360 bars ?

Sur le point 3. sachez que je suis habilité à diriger des recherches et qu’à ce titre j’ai dirigé plusieurs thèses dont celle de Aurore Voldoire que vous trouverez à l’adresse suivante : https://theses.fr/2005TOU30024

Le titre est évocateur : « Prise en compte des changements de végétation dans un scénario climatique du XXIème siècle ».

Si on parle de cursus scientifique, j’aimerai connaître le vôtre.

Truffé d’erreurs ? Mais bien sûr . Toujours plus facile d’accuser les autres que de se remettre en cause. Vous m’avez l’air d’être un drôle de scientifique.

Une seule thèse ? Diantre quel record. Ceci ne vous empêche pas de mal connaître les programmes des cursus scientifiques. La thermodynamique est au programme de la deuxième année de licence de physique à l’université.

Je suis professeur de physique.PR1. HDR Mais pas qu’une seule thèse.

J’exerce en Alsace.

Monsieur Cooper,

J’ai téléchargé l’article de Nature que vous m’avez indiqué : Physical, chemical and biological processes in Lake Vostok and other Antarctic subglacial lakes. C’est un article ancien : NATURE |VOL 414 | 6 DECEMBER 2001 |www.nature.com, qui a été écrit avant que les russes ne percent la voûte du lac Vostok.

Cet article indique effectivement une pression de l’eau du lac de 350 atmosphère dans le résumé (fin de la quatrième ligne) ce qui donne une estimation de 354,6 bars.

On sait maintenant qu’il y a de l’air au-dessus du lac alors que l’article en question suppose que la glace est en contact direct avec l’eau du lac et fait pression sur elle.

Si l’eau du lac était à la pression de 354 bars, l’eau aurait jailli comme un geyser que les russes n’auraient pas pu arrêter quand ils ont percé la voûte du lac.

Votre phrase est un copié/collé de Wikipédia et votre citation de cette article ancien est seulement destinée à donner le change et faire croire à vos compétences en physique et au titre de professeur que vous vous attribuez.

On comprend que vous teniez à votre anonymat.

Pr Sheldon Cooper : » Je suis professeur de physique.PR1. HDR. »

Et c’est la marmotte qui met le chocolat dans le papier…

Dans ce cas citez une thèse que vous avez dirigé et donnez l’adresse à laquelle on peut la lire.

Si vous êtes ce que vous dites répondez à ma question sur la pression de 960 bars du lac Vostok.

Je ne peux pas le faire. Je tiens à mon anonymat. Et je ne vais pas m’inventer une fausse identité non plus.

Pour les -3°C et la pression : Physical, chemical and biological processes in Lake Vostok and other Antarctic subglacial lakes parue dans Nature.

Monsieur Cooper,

J’ai téléchargé l’article de Nature que vous m’avez indiqué : Physical, chemical and biological processes in Lake Vostok and other Antarctic subglacial lakes. C’est un article ancien : NATURE |VOL 414 | 6 DECEMBER 2001 |www.nature.com, qui a été écrit avant que les russes ne percent la voûte du lac Vostok.

Cet article indique effectivement une pression de l’eau du lac de 350 atmosphère dans le résumé (fin de la quatrième ligne) ce qui donne une estimation de 354,6 bars.

On sait maintenant qu’il y a de l’air au-dessus du lac alors que l’article en question suppose que la glace est en contact direct avec l’eau du lac et fait pression sur elle.

Si l’eau du lac était à la pression de 354 bars, l’eau aurait jailli comme un geyser que les russes n’auraient pas pu arrêter quand ils ont percé la voûte du lac.

Votre phrase est un copié/collé de Wikipédia et votre citation de cette article ancien est seulement destinée à donner le change et faire croire à vos compétences en physique et au titre de professeur que vous vous attribuez.

On comprend que vous teniez à votre anonymat.

J’attends donc de votre part l’article plus récent qui viendra démontrer que les conclusions de celui ci son erronés.

Mais je crois que je vais attendre longtemps.

Voilà :

Twenty Years of Drilling the Deepest Hole in Ice

by Nikolay I. Vasiliev, Pavel G. Talalay, and Vostok Deep Ice Core Drilling Parties

doi:10.2204/iodp.sd.11.05.2011

https://www.researchgate.net/publication/283142245_Twenty_Years_of_Drilling_the_Deepest_Hole_in_Ice

C’est certes intéressant. Mais cette article ne parle pas de la température de l’eau. Il fait juste mention du record enregistré en 1983. -89°C Mais en surface. Il parle plus des techniques de forage qu’autre chose.

Assessing the subglacial lake coverage of Antarctica qui date de 2016 reprend cette température de -4°C.

Votre réponse montre votre confusion.

La température du lac que je n’ai jamais contestée n’est pas le sujet.

Le sujet c’est la pression de l’eau du lac.

Que dit votre article introuvable sur la pression de l’eau du lac ?

Introuvable pour qui ?

https://www.researchgate.net/publication/305691278_Assessing_the_subglacial_lake_coverage_of_Antarctica

Pauvre Monsieur Cooper,

Merci d’avoir donné l’adresse de l’article intitulé : « Assessing the subglacial lake coverage of Antarctica qui date de 2016 ».

Tout le monde pourra vérifier qu’il ne mentionne aucune température du lac Vostok.

On trouve seulement dans l’introduction la phrase suivante : « They are isolated (the subglacial lakes) from the circulation of the atmosphere and subject to permanent darkness, low temperatures of −2 to 4°C and enormous pressure of 22–40 bar (e.g. Carter and others, 2007). ».

Comme il n’y a dans cet article aucune autre allusion à la température du lac Vostok, on ne voit pas où vous pouvez bien trouver qu’il « reprend cette température de -4°C » pour vous citer.

Quand à l’énorme pression de 22 à 40 bar, c’est à dire environ 22 à 40 fois la pression atmosphérique l’article dont je vous rappelle le titre et l’adresse :

Twenty Years of Drilling the Deepest Hole in Ice

by Nikolay I. Vasiliev, Pavel G. Talalay, and Vostok Deep Ice Core Drilling Parties

doi:10.2204/iodp.sd.11.05.2011

https://www.researchgate.net/publication/283142245_Twenty_Years_of_Drilling_the_Deepest_Hole_in_Ice

démontre de manière factuelle que l’eau du lac Vostok n’est nullement sur-compressée : les auteurs expliquent la manière dont ils ont procédé quand ils ont percé la voûte de glace du lac Vostok à un endroit elle est immergée. Ils ont compensé la différence de pression en apportant de l’eau dans le trou. Une fois l’opération terminée, du fait que le trou est en communication avec l’air libre, la pression de l’eau du lac à sa surface est la pression atmosphérique. Bien sûr, la pression de l’eau du lac augmente avec la profondeur suivant la loi de l’hydrostatique.

Je n’attend pas de vous que vous ayez l’honnêteté de reconnaître vos erreurs, mais j’arrête là la discussion que je n’ai menée que pour les personnes qui s’intéressent aux sujets dont je parle et que je peux expliquer scientifiquement.

Je vous suggère de reprendre des études scientifiques par correspondance dans ce cas.

Vous apprendrez à trouver des articles introuvables.

Nouvelle humiliation du Pr Cooper, écrasé, laminé, discrédité; continuez à nous faire rire.

L’important pour vous c’est d’y croire….

L’important pour moi c’est d’être factuel, les autres membres du forum font le même constat.

Retournez plutôt sur vos sites pornos faire le plein de photos que vous pourrez répandre là ou vous en avez l’habitude. Et puis c’est bientôt la commémoration du 7 octobre, vous allez pouvoir déverser votre antisémitisme à loisir…

Et bien factuellement et scientifiquement vous ne valez rien.

Je le répète, Pr Sheldon Cooper est un troll.

C’est un petit prof de lycée frustré qui joue au physicien sur les forums. Il se fait régulièrement humilier dans les discussions scientifiques dès qu’il tombe sur un interlocuteur compétent. Mais comme il n’a pas le niveau, il fait diversion en ignorant les réponses qu’on lui apporte, en posant des questions sans objet, en niant les arguments et les données qu’on lui fourni et masque son imposture avec tout ce qu’il peut attraper sur le net, sans y comprendre grand chose.

Il continuera coûte que coûte à étaler son ignorance quoiqu’il arrive, au mépris de toute réalité.

Il ne faut pas trop lui en vouloir, c’est un médiocre qui essaie péniblement d’exister.

Petit ? Tout dépend. Ma CNI indique 1,80 m. Prof oui. De lycée non. Physicien oui. Humiliation je ne sais pas. Par contre je sais que je lis beaucoup de bêtises sur la plupart des forums.

Maintenant si bien sûr votre but c’est de foncer dans le n’importe quoi qui meuble je ne ferais pas le poids.

Effectivement vous ne faites pas le poids, sauf dans le n’importe quoi dont vous meublez chacun de vos posts.

Continuez à nous faire rire.

Ben voyons…

Je vous remercie Monsieur Carpenter.

Le Pr Sheldon Cooper est bien un troll.

En effet, il suffit de voir la figure 6. de l’article intitulé » Comment les nuages affectent les saisons » dont l’abscisse désigne la température observée par le satellite CERES de la NASA au sommet des nuages.

On peut voir sur cette figure que le satellite en question observe des températures au sommet des nuages jusqu’à -60°C et que c’est bien une limite car il n’y a pas d’observation à des températures inférieures.

Je n’ai pas perdu mon temps à discuter avec ce Monsieur Cooper car j’ai pu démontrer de manière factuelle que son niveau de compréhension scientifique est proche de la nullité, ce qui confirme qu’il est bien un troll.

Monsieur Cooper n’est pas le seul troll à s’exprimer sur ce site. Ils ont tous en commun de croire les théories discutables prônées par le GIEC que de nombreux scientifiques compétents mettent en doute : voir l’article intitulé » De bonnes nouvelles en provenance de la République Tchèque « .

Monsieur Cooper a commenté cet article : » Des scientifiques sérieux publient dans des articles à comité de lecture. « . Il se trouve que j’ai publié de nombreux articles dans des revues à comité de lecture et que d’après ses propres critères je suis donc un scientifique sérieux, par contre Monsieur Cooper est un troll comme ses compères Jack et Sommer.

Paul Pettré

A un moment il faudrait être précis. Vous parlez de quoi ? Des nuages ou des icebergs ?

Je parle du diagramme des phases de l’eau. Les nuages contiennent de l’eau sous ses trois phases. Un iceberg c’est de l’eau sous sa forme solide. Si on veut comprendre le comportement des nuages, il est indispensable de connaître les lois de la thermodynamique et le diagramme des phases qui s’applique aussi à un iceberg,

Pas aux températures que vous indiquiez en tout cas.

Précisément si puisque tous les diagrammes de phases de l’eau établis avec les lois de la thermodynamique indiquent comme limite de la sublimation de la glace une température de -60 degrés Celsius.

Vous ne faites que montrer votre incapacité à comprendre ce que dit un diagramme de phases sur la physique des systèmes thermodynamiques.

C’est complètement faux. Je pense que vous avez de graves lacunes dans le domaine de la thermodynamique.

Vous c’est dans tous les domaines que vous avez de graves lacunes.

Vous voilà une fois de plus ridiculisé, continuez à nous faire rire, « professeur »…

Pas vraiment en fait. Moi je ne dis pas que des collègues scientifiques ne comprennent pas un diagramme..

Vous préférez préférez dénigrer vos contradicteurs en les traitant d’alcoolique. Question d’éducation, sans doute.

Pas vraiment en fait

M Pettré,

Un grand merci pour ce petit rappel concernant la surfusion de l’eau pure. La thermodynamique est une branche de la physique difficile à appréhender par les ingénieurs comme moi et même par les scientifiques pur jus. Pour le premier principe évoquant la conservation de l’énergie, c’est ok, mais pour le second, c’est plus délicat, car la notion d’entropie est difficile à admettre, puisqu’il s’agit de la mort (ou désagrégation) mise en équation. il faut atteindre un âge avancé (j’ai 80 ans) pour l’admettre.

Ceci dit, revenons à l’Antarctique puisque vous connaissez fort bien ce continent glacé. Ainsi il y aurait de l’eau liquide à la base de l’inlandsis Il y en a aussi dans les nuages, ce qui donne le verglas où l’eau de pluie surfondue gèle instantanément au contact d’une surface solide ( feuilles des arbres, grillage des clôtures et malheureusement aussi ailes des avions). Ne serait-ce pas la raison pour laquelle les glaciers glissent si bien sur leur fond rocheux ?

Je ne suis pas un scientifique du climat mais je m’intéresse un peu à la glaciologie. En 1961, en vacances aux Bossons, je montais tous les jours au chalet du glacier (1500 m d’altitude). Il y avait à l’époque une grotte de glace semblable à celle de la Mer de glace. Aujourd’hui il n’y a plus que des cailloux. Sniff !

Par curiosité, je relève chaque jour les températures de surface de nos deux inlandsis (sites « windyty.com » – planisphère et « earth.nullschool.net » – mappemonde)

En ce jour du 15 septembre, à une semaine de l’équinoxe d’automne, j’ai noté les valeurs suivantes à peu près au centre de ces régions perpétuellement englacées (en bleu ou violet) :

Antarctique (78,50 S, 44,63 E) : moins 69°C . Le printemps est proche, le jour se lève !

Groenland (73,07 N, 37,47 O) : moins 34,8 °C. L’automne arrive, le soleil se couche !

En effet, dans la situation actuelle, l’entropie des glaciers alpins est négative, ce qui entraîne leur recul parce que l’accumulation des précipitations neigeuses sur eux ne compense pas leur fonte.